[AI타임즈] '어텐션' 없는 새로운 AI 아키텍처 '파워 리텐션' 등장

페이지 정보

작성자

xtalfi

작성일

2025.11.06 17:52

본문

| AI 도구 | Gemini |

|---|---|

| 프롬프트 | Https://www.aitimes.com/news/articleView.html?idxno=203746 자세하게 내용 정리 |

'어텐션' 없는 새로운 AI 아키텍처 '파워 리텐션' 등장

(AI타임스 기사 요약, 2025.11.06 업데이트)

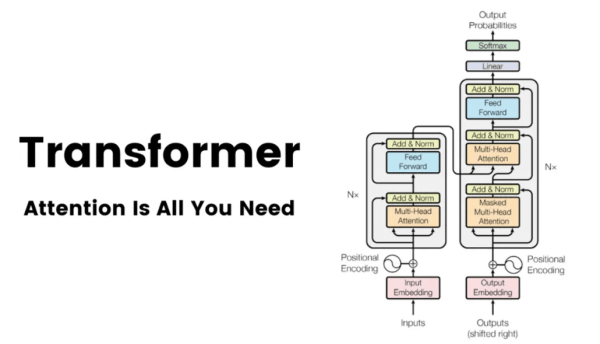

대규모 언어 모델(LLM)의 기반인 '트랜스포머'를 대체하는 새로운 AI 아키텍처 '파워 리텐션(Power Retention)'이 등장했습니다. 이는 기존 '어텐션' 메커니즘의 비효율적인 연산 비용 문제를 해결하며, 획기적인 비용 절감과 성능 유지를 목표로 합니다.

1. 새로운 아키텍처의 등장 배경

- 기존 트랜스포머의 한계: 트랜스포머의 핵심인 '어텐션(Attention)' 메커니즘은 입력 시퀀스(문장 길이)가 길어질수록 연산량과 메모리 비용이 제곱(N²)으로 증가하는 비효율성을 초래합니다.

- 대체 아키텍처: 미국 AI 스타트업 매니페스트 AI(Manifest AI)가 이러한 한계를 극복하기 위해 자체 개발한 '파워 리텐션' 구조를 도입했습니다.

2. '파워 리텐션'의 특징 및 원리

- '어텐션' 제거: '브럼비-14B-베이스(Brumby-14B-Base)' 모델은 기존 트랜스포머의 어텐션 레이어를 완전히 제거했습니다.

- 순환 구조(RNN) 채택:

- 모든 단어 쌍을 비교하는 대신, 이전 정보(기억)를 계속 압축해 업데이트하는 방식을 사용합니다.

- 이 덕분에 문장 길이가 아무리 늘어나도 **토큰당 계산 비용이 크게 증가하지 않아** 처리 속도가 거의 일정하게 유지됩니다.

- 기억력 및 표현력: 입력 간의 복잡한 관계(고차 의존성)를 잘 파악하며, 긴 문맥 속에서도 중요한 정보를 잃지 않는 장기 의존성 유지 능력이 뛰어납니다.

- 평가: 전문가들은 이를 "RNN의 효율성과 트랜스포머의 표현력을 결합한 차세대 AI 아키텍처"로 평가합니다.

3. 효율성 및 성능 결과

| 구분 | 트랜스포머 (기존) | 파워 리텐션 (브럼비-14B) |

|---|---|---|

| 연산/메모리 비용 | 시퀀스 길이에 따라 제곱으로 증가 (O(N²)) | 시퀀스 길이가 늘어나도 **일정하게 유지** (O(N)) |

| 학습 비용 (14B 모델 기준) | 매우 높음 | 약 4,000달러 소요 (같은 규모 트랜스포머의 **2% 이하**) |

| 벤치마크 성능 | 기준 모델 역할 | 주요 벤치마크에서 **동등하거나 우수한 성능** 기록 |

| 특징 | 장문 추론 및 수학적 문제 해결에서 **더 안정적인 성능** |

4. 의의 및 공개

- 매니페스트 AI는 이번 출시가 카네기멜론대학교의 **'맘바(Mamba)'** 등과 함께 **'포스트 트랜스포머' 시대**를 앞당길 것이라 기대합니다.

- '브럼비-14B-베이스'는 현재 허깅페이스에 오픈 소스로 공개되어 있습니다.

댓글 0