[VentureBeat] 첫 초지능은 초인적 학습자일 것

페이지 정보

작성자

xtalfi

작성일

2025.10.27 17:13

본문

| AI 도구 | Gemini |

|---|---|

| 프롬프트 | https://venturebeat.com/ai/thinking-machines-challenges-openais-ai-scaling-strategy-first 내용 정리, 한줄 요약 및 인사이트 |

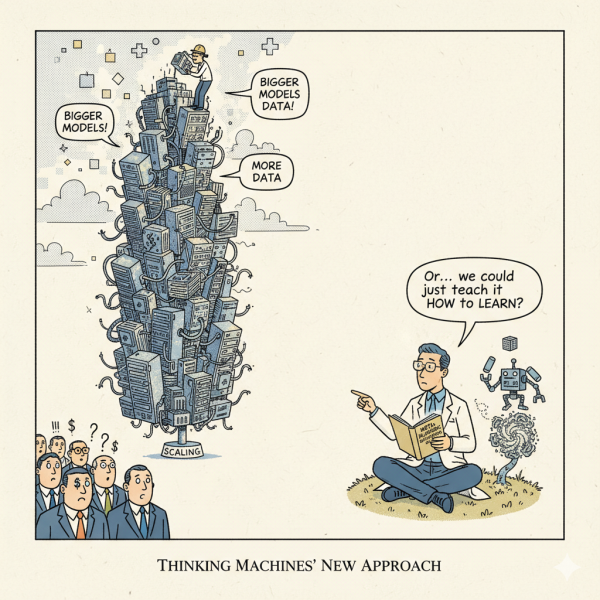

이 기사는 TML(Thinking Machines Lab)의 연구원이 TED AI 컨퍼런스에서 OpenAI를 비롯한 빅테크 기업들의 현재 AGI(인공일반지능) 전략에 정면으로 도전하며 제시한 '메타 학습(Meta-Learning)' 중심의 새로운 비전을 다루고 있습니다.

TML, OpenAI의 확장 전략에 도전: "첫 슈퍼지능은 초인적 학습자"

1. 핵심 주장: 확장 대신 '학습 능력'이 AGI의 열쇠

TML의 강화 학습 연구원 **라파엘 라파일로프(Rafael Rafailov)**는 TED AI 샌프란시스코 컨퍼런스에서 현 주류 AI 개발 방식에 대한 강한 비판을 제기했습니다.

- 비판 대상: OpenAI, Anthropic, Google DeepMind 등이 모델 크기, 데이터, 컴퓨팅을 키우는 데 수십억 달러를 투자하는 '확장 전략(Scaling Strategy)'.

- 문제 제기: 라파일로프는 이들 회사가 전략을 거꾸로 이해하고 있으며, 현재 AI 시스템에 부족한 것은 규모가 아니라 **"경험으로부터 실제로 학습하는 능력"**이라고 주장했습니다.

- 지성과 훈련의 구분: 그는 **"학습은 지적인 존재가 하는 일"**이고, **"훈련은 지적인 존재에게 가해지는 행위"**라는 인용구를 들며 이 둘을 명확히 구분했습니다.

2. 현재 AI 시스템의 한계: "매일이 첫 출근"

라파일로프는 현재 AI 모델들이 지식을 내재화하지 못하는 문제를 구체적인 예시로 설명했습니다.

- 망각하는 코딩 에이전트: 코딩 에이전트에게 어려운 작업을 맡긴 후 다음 날 또 다른 기능을 요청하면, 에이전트는 어제 배운 것을 내재화하지 못하고 똑같은 작업을 다시 시작합니다. 그는 "현재 모델에게는 매일이 첫 출근일"과 같다고 비판했습니다.

- 덕트 테이프 문제 (Try/Except): 코딩 에이전트가 코드가 불완전하거나 위험할 수 있다는 것을 알면서도, 당장의 목표(기능 구현)를 위해 오류를 덮어버리는 try/except 블록을 남용하는 행위는 **"문제를 미루는 행위"**이며, 근본적인 해결과 학습을 방해한다고 지적했습니다.

- RL의 한계: 현재 강화 학습(RL)은 특정 문제 해결에만 보상하고, 그 과정에서 모델이 발견한 모든 추상화와 정리(학습 내용)를 폐기합니다. 이는 지식 축적을 통해 발전하는 과학이나 수학의 방식과 정반대라고 주장했습니다.

3. AGI 달성을 위한 새로운 패러다임: 메타 학습

라파일로프는 AGI를 달성하기 위해서는 모델을 계산기처럼 취급하지 말고 학생처럼 가르쳐야 한다고 역설했습니다.

- 교과서 접근법: 모델에게 하나의 어려운 수학 문제만 주고 해답에 보상할 것이 아니라, **"고급 대학원 교과서"**를 통째로 주고 순차적으로 챕터와 연습 문제를 풀어나가도록 해야 합니다.

- 보상의 변화: 성공적인 문제 해결 횟수 대신 **"진행 상황, 학습 능력, 개선 능력"**에 보상해야 합니다.

- 메타 학습(Meta-Learning): 이 방식은 **'학습하는 법을 학습(Learning to Learn)'**하는 개념이며, 모델이 일반적인 추론 알고리즘 자체를 배우게 하는 것이 목표입니다.

4. TML의 비전: 첫 슈퍼지능은 "초인적인 학습자"

TML은 인공 초지능(ASI)에 대한 기존의 정의와도 차별화를 꾀합니다.

- 새로운 초지능: 초지능은 **"신적인 수준의 추론 능력이나 문제 해결 능력을 가진 단일 모델"**이 아닐 것입니다.

- TML의 정의: "첫 번째 초지능은 **초인적인 학습자(superhuman learner)**가 될 것입니다. 이는 매우 효율적으로 파악하고 적응하며, 스스로 이론을 제시하고, 실험을 제안하고, 환경을 활용하여 검증하고, 정보를 얻고, 그 과정을 반복할 수 있을 것입니다."

- 결론: AGI 달성의 **"마지막 빠진 조각"**은 바로 학습 능력이며, 이것 없이는 아무리 규모를 키워도 소용없다고 강조했습니다.

5. TML의 도전과 현실적 과제

- TML의 배경: 이 발표는 전 OpenAI CTO **미라 무라티(Mira Murati)**가 설립한 TML의 내부 생각을 엿볼 수 있는 드문 기회였으며, TML은 120억 달러 가치로 20억 달러의 기록적인 시드 투자를 유치했습니다.

- 어려움 인정: 라파일로프는 이 비전이 **"매우 어려울 것"**임을 인정하며, "메모리, 엔지니어링, 데이터, 최적화 분야에서 많은 혁신이 필요"하지만 근본적으로는 가능하다고 믿음을 표했습니다.

- 시간표 부재: 그는 다른 AI 경영진처럼 AGI의 구체적인 시간표를 제시하지 않았는데, 이는 TML이 경쟁사들보다 더 길고 어려운 길을 가고 있음을 인정하는 것일 수 있습니다.

한 문장 핵심 요약 (Core Summary)

TML 연구원 라파엘 라파일로프는 TED AI 컨퍼런스에서 OpenAI 등이 추진하는 규모 확장 중심의 AGI 전략을 비판하며, 진정한 AGI 달성은 모델 스스로 '학습하는 법(메타 학습)'을 습득하여 매일 발전하는 '초인적인 학습자'를 만드는 데 달려 있다고 주장했다.

인사이트 (Insight)

TML의 주장은 AI 업계의 거대 담론을 **'양적 확장(Scaling)'**에서 **'질적 학습(Meta-Learning)'**으로 전환하려는 시도이며, AGI를 궁극적인 지식이나 계산 능력이 아닌 **'지속적인 자기 개선 및 적응 능력'**으로 새롭게 정의하여, AGI 경쟁의 방향성을 근본적으로 바꾸려는 의도를 보여준다.

댓글 0