[AI타임즈] '트랜스포머' 저자가 "트랜스포머에 질린다"라고 한 이유

페이지 정보

작성자

xtalfi

작성일

2025.10.25 17:37

본문

| AI 도구 | Gemini |

|---|---|

| 프롬프트 | Https://www.aitimes.com/news/articleView.html?idxno=203416 내용 정리 |

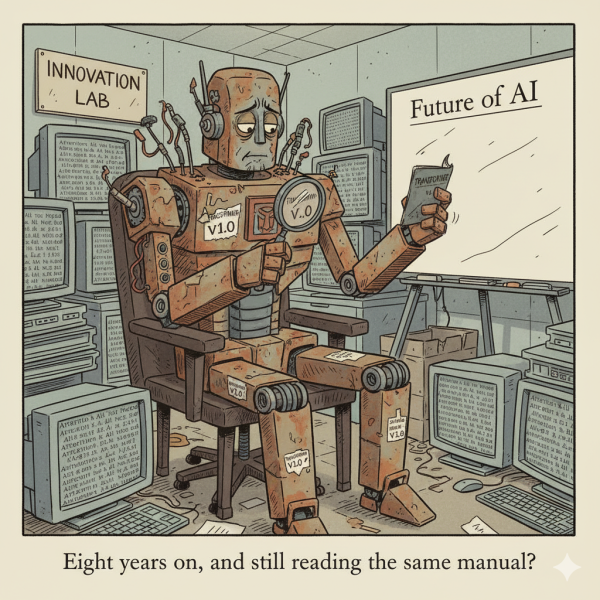

AI타임스 기사 내용 요약: '트랜스포머' 저자가 "트랜스포머에 질린다"라고 한 이유

**기사의 핵심 주제는 '트랜스포머' 모델 공동 저자 중 한 명인 일리언 존스(Illia Polosukhin, 사카나 AI 공동 창립자)가 현재의 AI 연구가 위험할 정도로 **협소한 분야(트랜스포머)에 집착하고 있음을 비판하며, 차세대 아키텍처 개발에 더 많은 자원을 투자해야 한다고 강조한 내용입니다.

주요 내용

- AI 연구의 협소화 비판:

- 존스 창립자는 미국 샌프란시스코에서 열린 TED AI 콘퍼런스에서 AI 업계에 대한 쓴소리로 "트랜스포머에 질린다"고 말했습니다.

- 막대한 자원과 재능이 투입되고 있음에도 불구하고, AI 연구의 범위는 점점 좁아지고 있다고 지적했습니다.

- 트랜스포머 의존 현황:

- 현재의 대규모 언어 모델(LLM)과 생성형 AI는 모두 2017년 구글 논문 **'Attention is all you need'**에서 비롯된 트랜스포머(Transformer) 아키텍처를 기반으로 하고 있습니다.

- 심지어 GPT(Generative Pre-trained Transformer)의 약자에도 트랜스포머가 포함되어 있으며, 8년이 지난 현재까지도 가장 중요한 기본 구조는 변하지 않았습니다.

- 이러한 현상은 투자자들의 수익률 요구와 연구자들이 경쟁에서 두각을 나타내야 한다는 압박 때문이라고 분석했습니다.

- 혁신의 부재 및 한계:

- 세계 최고의 인재와 막대한 비용이 투입되고 있지만, 기존의 틀에서 벗어나려는 진정한 혁신에는 관심이 적으며, 최신 연구 역시 8년 전 아키텍처에서 효율을 짜내기 위한 것에 불과하다고 비판했습니다.

- 트랜스포머 구조는 대규모 데이터 학습이 필수적이기에 모델 개발 비용이 천문학적인 수준으로 치솟았으나, 성능 향상은 더뎌지는 한계에 직면했습니다.

- 대안 및 제안:

- 존스 창립자는 현 연구에 투자되는 비용 중 일부를 새로운 아키텍처 개발에 투자하여 AI를 완전히 새로운 차원으로 도약시켜야 한다고 제안했습니다.

- '맘바(Mamba)', '액체 신경망(LNN)', 이미지 생성의 디퓨전(Diffusion) 방식을 언어 모델에 접합하는 시도 등이 있으나, 아직 트랜스포머를 능가할 뚜렷한 장점을 보이지 못하고 있습니다.

- 그는 AI 연구계가 **"자원이 늘어날수록 창의성이 줄어드는 역설"**에 직면했다고 지적하며, 경쟁이 아닌 협력을 통해 탐구의 폭을 넓히고 발견한 것을 공개적으로 공유해야 한다고 결론 내렸습니다.

댓글 0