구글·메타·오픈AI, 서울서 오픈소스 AI 안전성 논의

페이지 정보

본문

(퍼플렉시티가 정리한 기사)

구글, 메타, 마이크로소프트, 오픈AI 등 글로벌 AI 기업들이 15일 서울에 모여 오픈소스 AI의 안전한 활용방안을 논의했다. 개인정보보호위원회가 개최한 ‘오픈소스 데이’에는 국내외 AI 기업과 연구자, 감독기구 관계자 등 120여 명이 참석해 프라이버시 보호와 오픈소스 AI 생태계 구축방안을 집중 논의했다.

글로벌 AI 기업들의 안전성 강화 방안 제시

구글은 오픈소스 모델 운영 플랫폼 ‘버텍스(Vertex) AI’를 소개하며 신용카드, 여권번호 등 민감정보를 걸러내는 안전성 강화 도구와 정량적 평가방법을 접목한 프롬프트 최적화 기술을 공유했다.

메타는 오픈소스 AI 필터링 모델 ’라마 가드(Llama Guard)’를 소개했으며, 에임 인텔리전스는 이를 한국 실정에 맞게 고도화해 ‘라마 임팩트 이노베이션 어워즈’를 수상한 사례를 공유했다.

마이크로소프트는 ‘애저 AI 파운드리’를 기반으로 에이전트 AI 구축 사례를 제시하며 차세대 패러다임으로 주목받는 에이전트 AI 구축을 위한 오픈소스 모델 활용 가능성을 제시했다.

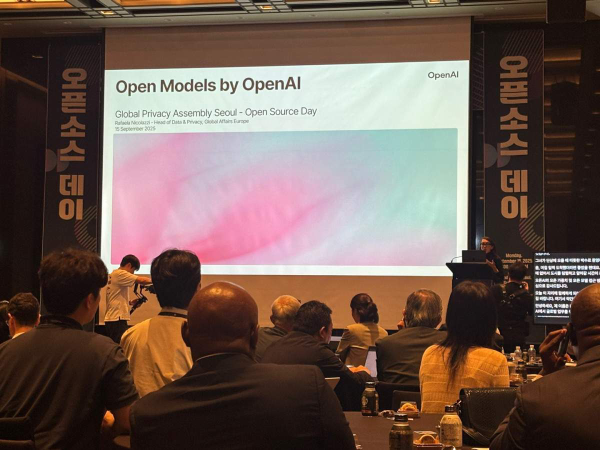

오픈AI 6년 만에 오픈소스 모델 공개

오픈AI는 최근 새롭게 공개한 자사 오픈소스 모델 ‘gpt-oss-20b/120b’를 소개했다. 이는 GPT-2 이후 6년 만에 공개된 오픈소스 모델로, 120억 개와 20억 개의 파라미터를 각각 보유한 두 가지 버전이다.

오픈AI는 이 모델들이 지닌 경제적, 사회적 가치와 함께 안전성 우려와 책임성, 글로벌 차원의 논의 필요성 등 오픈소스 확산 과정에서 직면한 과제도 제기했다.

개인정보 보호와 안전성 확보 방안 논의

개인정보보호위원회가 사전 실시한 설문조사에 따르면, 응답자 70명 중 62%가 오픈소스 도입·활용 경험이 있다고 응답했으며, 77%는 오픈소스 모델 활용 시 안전성을 고려한 경험이 있다고 밝혔다.

참석자들은 오픈소스 AI 도입 과정에서 개인·민감정보 필터링 및 검증 절차, 미세조정 시 고려사항, 레드팀 테스트 설계 방안 등 안전성 및 신뢰성 보장 방안을 집중적으로 논의했다.

네이버는 자사 오픈소스 모델 ‘하이퍼클로바X’와 함께 AI 편향성과 불안전성 관련 데이터셋을 공개했으며, 서비스 개발 과정에서 민감한 정보는 수집하지 않는다고 강조했다.

국제적 공감대 형성

이날 행사는 16일 개막한 제47차 글로벌 프라이버시 총회(GPA)의 사전 부대행사로, 한국을 비롯한 영국, 이탈리아, 브라질 등 4개국 개인정보 감독기구가 패널로 참석한 라운드테이블도 진행됐다.

최장혁 개인정보보호위원회 부위원장은 “이번 오픈소스 데이는 에이전트 AI와 같은 혁신 서비스의 기반이 되는 오픈소스 AI 생태계와 개인정보 보호를 함께 고민하는 국내 첫 공개 논의의 장”이라고 의미를 부여했다.