OpenAI GTP-5를 잘 쓰기 위한 프롬프트 가이드 공개

페이지 정보

본문

오픈AI가 출시하고 불만이 많아진 GPT-5를 잘쓰기 위한 프롬프트 가이드를 공개했다.

https://cookbook.openai.com/examples/gpt-5/gpt-5_prompting_guide?ref=blog.secondbrush.co.kr

이 가이드에서는 모델을 학습하고 실제 작업에 적용해 온 경험을 바탕으로 모델 출력의 품질을 극대화하기 위한 프롬프트 팁을 다루고 있다.. 에이전트 작업 성능 향상, 명령어 준수 보장, 새로운 API 기능 활용, 프런트엔드 및 소프트웨어 엔지니어링 작업을 위한 코딩 최적화 등의 개념을 살펴보고, GPT-5를 활용한 AI 코드 편집기 Cursor의 프롬프트 튜닝 작업에 대한 핵심 인사이트도 제공한다고..

가이드에 따르면,

"모범 사례를 적용하고 가능한 한 표준 도구를 도입함으로써 상당한 성과를 거두었으며, 이 가이드와 저희가 개발한 프롬프트 최적화 도구가 GPT-5 사용의 발판이 되기를 바랍니다. 하지만 항상 그렇듯이 프롬프트는 모든 경우에 적용되는 것은 아니라는 점을 명심하십시오. 여기에 제시된 기반을 바탕으로 실험을 수행하고 반복하여 문제에 대한 최상의 해결책을 찾을 것을 권장합니다."라고 되어 있다.

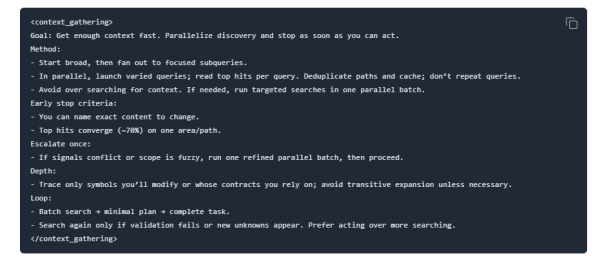

Goal: Get enough context fast.

목표: 빠르게 충분한 콘텍스트를 얻는다.

Parallelize discovery and stop as soon as you can act.

탐색을 병렬로 진행하고, 행동할 수 있게 되면 즉시 중단한다.

Method:

방법:

Start broad, then fan out to focused subqueries.

먼저 넓게 시작하고, 이후에는 구체적인 하위 쿼리로 확장한다.

In parallel, launch varied queries; read top hits per query. Deduplicate paths and cache; don’t repeat queries.

다양한 쿼리를 병렬로 실행하고, 각 쿼리의 상위 결과를 읽는다. 경로는 중복 제거하고 캐시에 저장한다. 동일한 쿼리를 반복하지 않는다.

Avoid over searching for context. If needed, run targeted searches in one parallel batch.

콘텍스트를 지나치게 탐색하지 않는다. 필요할 경우, 한 번의 병렬 배치로 목표 검색을 수행한다.

Early stop criteria:

조기 중단 기준:

You can name exact content to change.

변경할 정확한 내용을 지정할 수 있다.

Top hits converge (~70%) on one area/path.

상위 결과의 약 70%가 한 영역 또는 경로로 모인다.

Escalate once:

한 번에 에스컬레이션한다:

If signals conflict or scope is fuzzy, run one refined parallel batch, then proceed.

신호가 상충하거나 범위가 불분명하면, 정제된 병렬 배치를 한 번 실행한 후 진행한다.

Depth:

깊이:

Trace only symbols you’ll modify or whose contracts you rely on; avoid transitive expansion unless necessary.

변경하거나 의존하는 심볼만 추적하고, 필요하지 않다면 전이적인 확장은 피한다.

Loop:

반복:

Batch search → minimal plan → complete task.

배치 검색 → 최소 계획 → 작업 완료.

Search again only if validation fails or new unknowns appear. Prefer acting over more searching.

검증에 실패하거나 새로운 미지의 요소가 나타난 경우에만 다시 검색한다. 추가 검색보다는 행동을 우선한다.