OpenAI, 긴 코딩 작업을 위한 GPT-5.1-Codex-Max 공개

페이지 정보

본문

(퍼플렉시티가 정리한 기사)

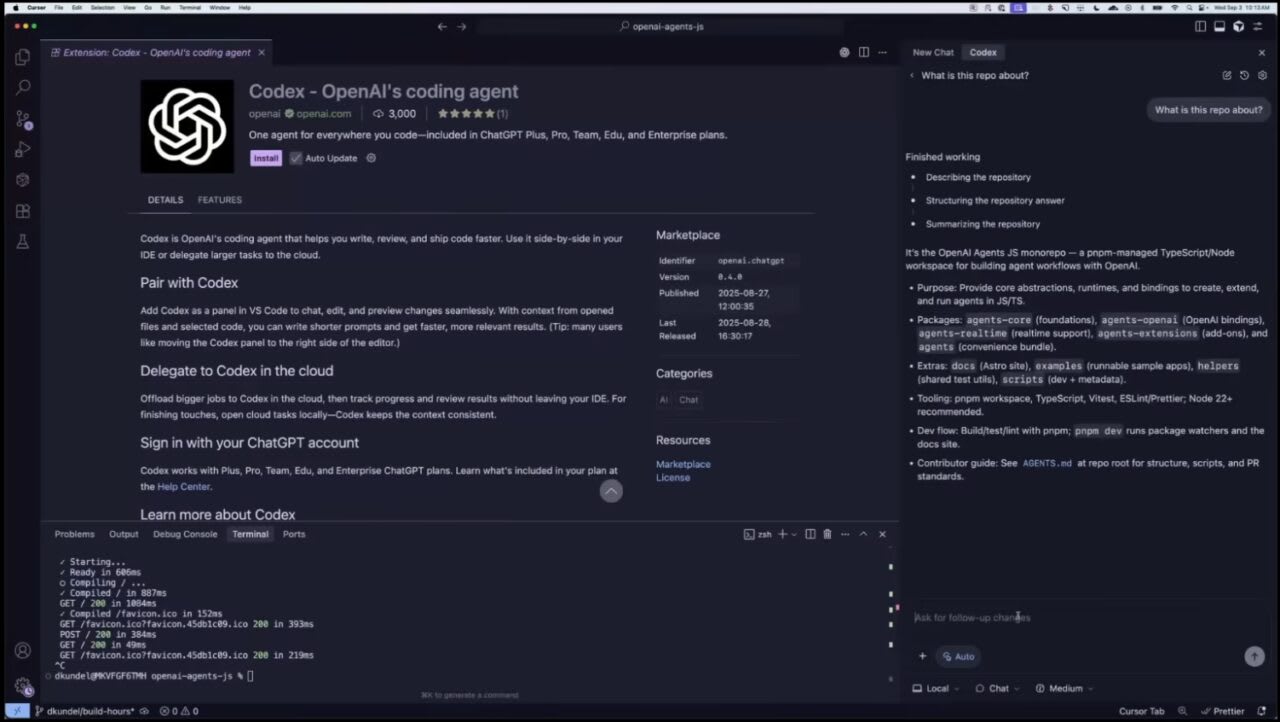

OpenAI는 월요일에 GPT-5.1-Codex-Max를 출시하며, 복잡한 다중 시간 프로그래밍 프로젝트를 다루는 개발자들을 위한 획기적인 최신 에이전틱 코딩 모델로 포지셔닝했습니다. 내부적으로 24시간 개발 작업을 완료한 것으로 알려진 이 모델은 컨텍스트를 잃지 않고 수백만 개의 토큰에 걸쳐 일관되게 작동할 수 있도록 하는 "압축(compaction)" 기술을 도입했습니다.

이번 출시는 Google이 Gemini 3 Pro를 공개한 지 하루 만에 이루어져, 개발자 도구 시장에서 AI 거대 기업들 간의 경쟁을 심화시키고 있습니다. OpenAI의 발표에 따르면, GPT-5.1-Codex-Max는 이제 모든 Codex 플랫폼에서 GPT-5.1-Codex를 대체하는 기본 모델이 되었습니다.

성능 향상 및 벤치마크 결과

GPT-5.1-Codex-Max는 표준 소프트웨어 엔지니어링 벤치마크인 SWE-Bench Verified에서 77.9%의 정확도를 달성하여, Gemini 3 Pro의 보고된 76.2%를 근소하게 앞질렀습니다. 이 모델은 또한 SWE-Lancer IC SWE에서 79.9%를 기록하여 이전 버전의 66.3%와 비교되며, TerminalBench 2.0에서는 58.1%에 도달했습니다.

벤치마크 점수를 넘어, 이 모델은 실질적인 효율성 개선을 제공합니다. OpenAI는 GPT-5.1-Codex-Max가 실제 코딩 작업을 완료할 때 GPT-5.1-Codex보다 약 30% 적은 토큰을 사용하면서 27%에서 42% 더 빠르게 작업을 완료한다고 보고합니다. ZDNET에 따르면, 이러한 효율성 향상은 사용량 제한이 있는 ChatGPT Plus 구독자들에게 잠재적으로 추가 1시간의 프로그래밍 시간으로 환산됩니다.

압축 시스템은 주요 아키텍처 발전을 나타내며, 컨텍스트 한계에 접근할 때 필수 정보를 유지하면서 세션 기록을 자동으로 압축할 수 있게 합니다. The Decoder에 따르면 "모델이 컨텍스트 창을 채우면 자동으로 세션 기록을 압축합니다". OpenAI의 시스템 카드는 이 모델이 "압축이라는 프로세스를 통해 여러 컨텍스트 창에 걸쳐 작동하도록 기본적으로 훈련된 최초의 모델"이라고 명시합니다.

가용성 및 내부 채택

GPT-5.1-Codex-Max는 ChatGPT Plus, Pro, Business, Edu 및 Enterprise 사용자를 위한 Codex를 통해 즉시 사용할 수 있습니다. OpenAI에 따르면 API 액세스는 "곧" 제공될 예정입니다. 이 모델은 또한 Windows 환경에 최적화된 최초의 Codex 버전입니다.

OpenAI 내부 채택률은 상당합니다. 회사의 10월 발표에 따르면, OpenAI 엔지니어의 95%가 매주 Codex를 사용하고 있으며, 이 도구를 채택하기 전과 비교하여 현재 70% 더 많은 풀 리퀘스트를 병합하고 있습니다. OpenAI는 "7월에 절반을 조금 넘었던 것에 비해 오늘날 거의 모든 엔지니어가 Codex를 사용합니다"라고 밝혔습니다.

이 모델은 프롬프트 인젝션 및 데이터 유출을 포함한 보안 위험을 완화하기 위해 기본적으로 네트워크 액세스가 비활성화된 샌드박스 환경 내에서 작동합니다.