마이크로소프트, 윈도우 11 AI 에이전트가 악성코드를 설치할 수 있다고 경고

페이지 정보

본문

(퍼플렉시티가 정리한 기사)

Microsoft는 최신 Windows 11 기능에 대해 강력한 경고를 발표하며, 사용자가 활성화할 경우 작업 자동화를 위해 설계된 AI 에이전트가 실수로 악성코드를 설치하거나 민감한 데이터를 유출할 수 있다고 주의를 당부했습니다.

이 기술 대기업은 2025년 11월 16일, Windows Insiders에게 "실험적 에이전트 기능"의 미리보기 버전을 배포하면서 경고를 발표했습니다. 발표와 함께 게시된 지원 문서에서 Microsoft는 이러한 AI 기능이 악성코드 설치 및 데이터 유출 가능성을 포함하여 "새로운 보안 위험을 초래한다"고 명시적으로 인정했습니다.

경고의 핵심은 크로스 프롬프트 인젝션(XPIA)이라는 취약점으로, 문서나 사용자 인터페이스 요소에 포함된 악성 콘텐츠가 에이전트의 명령을 무효화할 수 있습니다. Microsoft는 공식 문서에서 "UI 요소나 문서에 포함된 악성 콘텐츠가 에이전트 명령을 무효화하여 데이터 유출이나 악성코드 설치와 같은 의도하지 않은 작업을 초래할 수 있습니다"라고 밝혔습니다.

기본적으로 비활성화됨

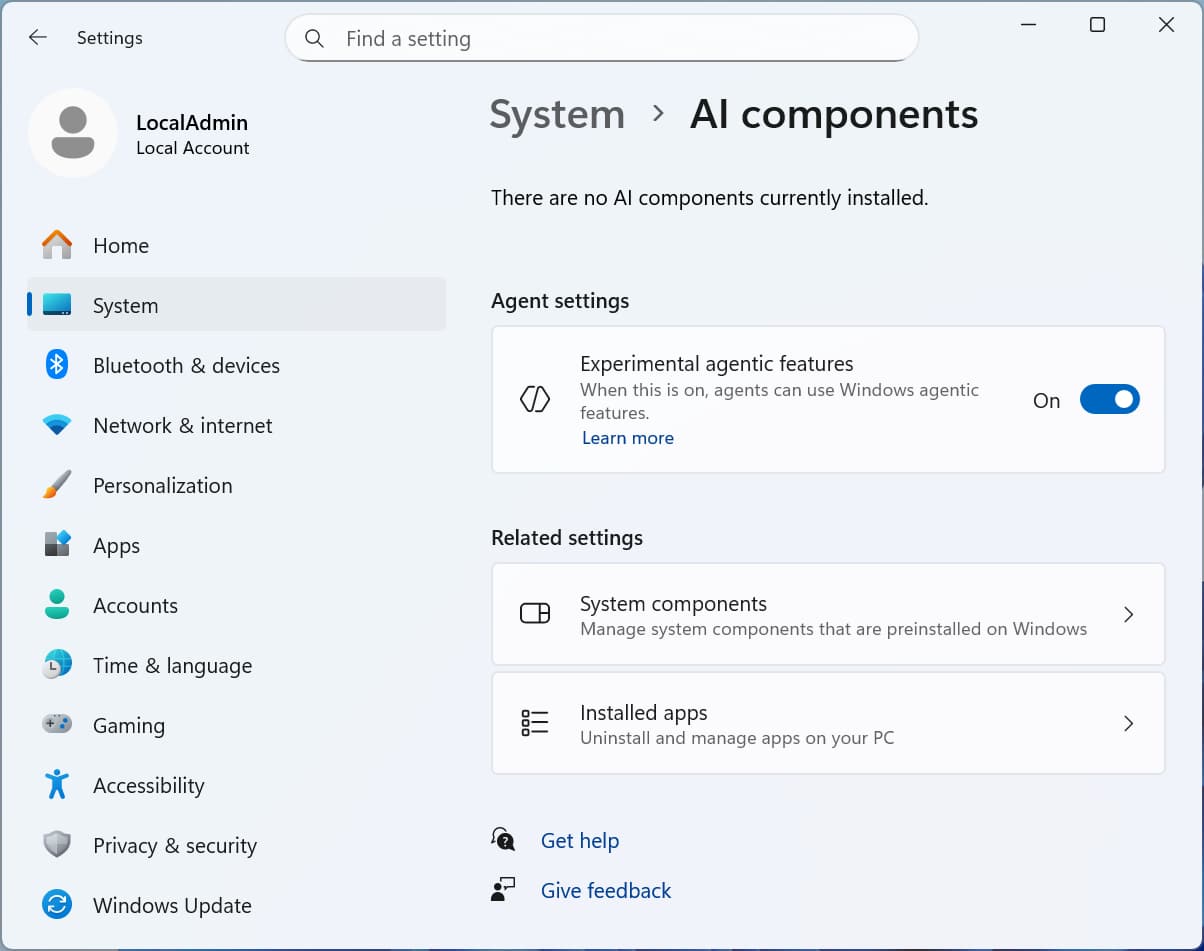

이러한 위험에 대응하여 Microsoft는 AI 에이전트 기능을 기본값이 아닌 선택 사항으로 만들었습니다. 회사는 사용자들이 "보안 영향을 이해하는 경우에만 이 기능을 활성화해야 한다"고 강조했습니다. 이러한 실험적 기능에 대한 토글은 설정 > 시스템 > AI 구성 요소 아래에 나타나며, 관리자만 활성화할 수 있습니다.

활성화되면 새로운 Agent Workspace는 AI 에이전트를 위한 별도의 사용자 계정을 생성하여, 문서, 다운로드, 바탕 화면, 비디오, 사진 및 음악을 포함한 개인 폴더에 대한 제한된 액세스 권한을 부여합니다. 이러한 에이전트는 사용자의 기본 데스크톱과 병렬로 격리된 환경에서 작동하여, 사용자의 주 세션을 방해하지 않으면서 파일 정리, 약속 예약 또는 이메일 전송과 같은 작업을 완료할 수 있습니다.

보안 안전장치

Microsoft는 위험을 완화하기 위해 여러 보안 제어를 구현했습니다. 모든 에이전트 작업은 사용자의 승인을 받아야 하며 "변조 방지 감사 로그"에 기록됩니다. 각 에이전트는 사용자 계정과 별도의 고유한 ID를 받아, IT 관리자가 에이전트 활동을 사람의 행동과 구별하여 추적할 수 있습니다.

이번 발표는 Microsoft의 Ignite 2025 컨퍼런스에서 이루어졌으며, 회사는 Windows를 "에이전트 기반 OS"로 만들겠다는 비전을 상세히 설명했습니다. 그러나 이 계획은 Microsoft가 AI 기능보다 안정성과 성능을 우선시해야 한다고 주장하는 사용자들의 비판에 직면했습니다.

보안 전문가들은 AI 에이전트가 기능적 한계에 직면하고 때때로 예상치 못한 출력을 생성하는 "환각" 현상을 보일 수 있지만, 단계적 출시 접근 방식은 Microsoft가 이 기술의 위험성을 인식하고 있음을 보여준다고 지적합니다. 이러한 기능을 활용할 것으로 예상되는 첫 번째 AI 애플리케이션은 Copilot Actions이지만, 현재 프리뷰 상태에서 이 기능을 지원하는 앱은 없습니다.