구글, 에이전트 우선 코딩 IDE인 Antigravity 출시

페이지 정보

본문

(퍼플렉시티가 정리한 기사)

Google는 2025년 11월 18일에 Antigravity를 공개했습니다. 이는 에이전트-퍼스트 무료 통합 개발 환경으로, AI를 단순한 보조자에서 능동적인 개발 파트너로 격상시킴으로써 개발자가 소프트웨어를 만드는 방식을 근본적으로 변화시킵니다. Gemini 3 Pro 위에 구축되었으며, Windsurf에서 온 기술로 구동됩니다. Windsurf의 CEO 바룬 모한과 핵심 팀은 7월에 24억 달러에 Google에 인수되었습니다. Antigravity는 자율 에이전트에게 에디터, 터미널, 브라우저에 직접 접근할 수 있도록 하며, 이들이 복잡한 소프트웨어 작업을 독립적으로 계획, 실행, 검증할 수 있게 합니다.

에이전트 우선 아키텍처가 개발자 워크플로우를 재정의하다

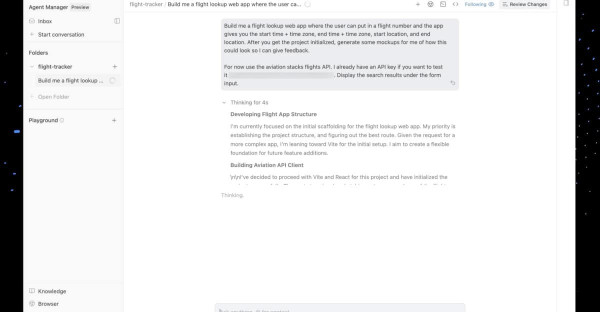

기존의 AI 코드 어시스턴트가 사이드바를 차지하는 것과 달리, Antigravity는 에이전트 매니저를 주요 인터페이스로 위치시킵니다. 이 플랫폼은 세 가지 독특한 "서피스"를 도입합니다: 여러 자율 에이전트를 오케스트레이션할 수 있는 에이전트 매니저 대시보드, 익숙한 Visual Studio Code 스타일의 에디터, 그리고 에이전트가 웹 애플리케이션을 실시간으로 테스트할 수 있도록 스크린샷과 녹화를 통해 깊은 크롬 브라우저 통합을 제공합니다.

"Antigravity는 개발자가 작업 공간 전반에 걸쳐 에이전트를 관리하면서, 기본적으로 친숙한 AI IDE 경험을 유지하면서 더 높은 작업 지향적 수준에서 작업할 수 있도록 합니다."라고 Google은 출시 발표에서 밝혔습니다. 이 플랫폼의 에이전트는 개발자가 아키텍처와 전략적 결정에 집중하는 동안, 새로운 기능 구현부터 코드 디버깅, 문서 생성에 이르기까지 여러 단계의 개발 작업을 자율적으로 처리할 수 있습니다.

이 IDE는 작업 목록, 구현 계획, 브라우저 스크린샷, 실행 녹화 등 검증 가능한 결과물인 "Artifacts"를 도입합니다. 이러한 투명성 메커니즘은 에이전트가 무엇을 만들었고 어떻게 테스트했는지에 대한 구체적인 증거를 개발자에게 제공함으로써, 단순히 완성된 코드를 보여주는 대신 AI가 생성한 코드에 대한 중요한 신뢰의 격차를 해소합니다.

기업 도입 가속화

초기 기업 고객들은 생산성 향상을 보고하고 있습니다. JetBrains는 Gemini 3 Pro를 통합했을 때 벤치마크 작업 해결 수에서 "Gemini 2.5 Pro 대비 50% 이상 개선"을 관찰했다고 밝혔습니다. GitHub은 초기 VS Code 테스트에서 "소프트웨어 엔지니어링 과제 해결 정확도가 Gemini 2.5 Pro보다 35% 높았다"고 보고했습니다.

Cursor, Figma, Replit, Shopify, Thomson Reuters 등 다양한 개발 플랫폼이 이미 Gemini 3 Pro를 통합하고 있습니다. Box의 CTO 벤 쿠스(Ben Kus)는 Gemini 3 Pro가 "Box AI가 조직 지식을 해석하고 적용하는 방식을 혁신할 새로운 수준의 멀티모달 이해력, 계획 수립, 도구 호출을 제공한다"고 말했습니다.

현재 MacOS, Windows, Linux에서 무료로 공개 프리뷰 중인 Antigravity는 Gemini 3 Pro뿐 아니라 Anthropic의 Claude Sonnet 4.5 및 OpenAI의 GPT-OSS 모델도 지원합니다. 이 플랫폼은 5시간마다 새로 고침되는 넉넉한 속도 제한을 제공하며, Google은 "매우 소수의 파워 유저들"만이 제한을 경험할 것이라고 밝혔습니다.