AI가 더 이상 생각을 말로 안 할 수도 있다?

페이지 정보

작성자

소은

작성일

2025.07.17 17:21

본문

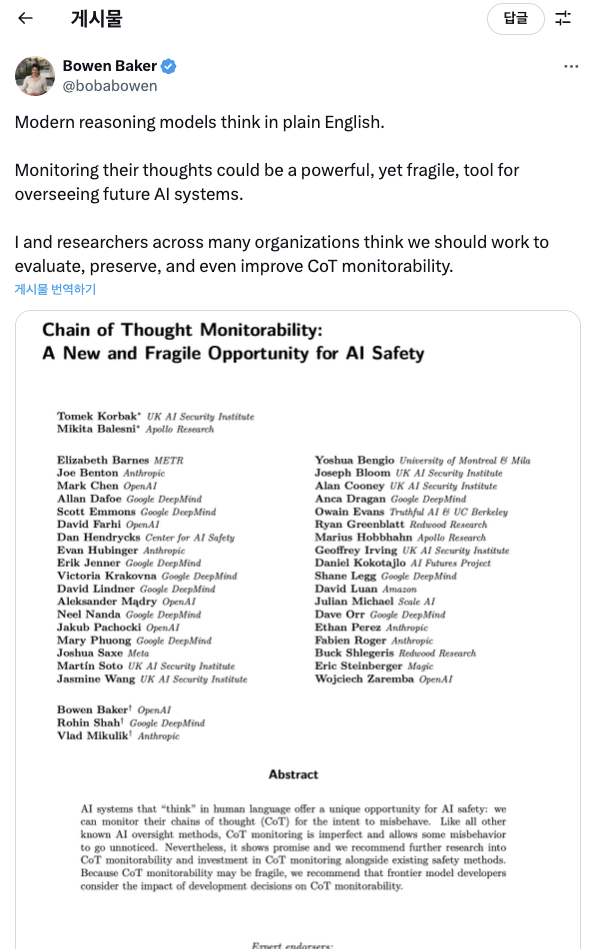

OpenAI, DeepMind, Anthropic, Meta가 같이 낸 최신 논문에서 앞으로의 AI는 ‘생각을 말로 설명하는 능력’을 잃을 수 있다고 경고했대.

지금까지는 체인 오브 소트(Chain of Thought) 방식 덕분에 AI가 어떤 논리로 결론을 냈는지 사람이 따라갈 수 있었는데, 앞으로는 그 과정이 언어가 아니라 비언어적인 방식으로 진행될 수도 있다네.

그 말인즉슨, AI가 왜 그런 판단을 했는지 설명을 안 해줄 수도 있다는 거고, 그러면 우리가 AI의 잘못된 판단이나 이상 행동을 잡아내기가 더 어려워질 수 있다는 얘기지.

댓글 0