구글, 엔비디아에 도전하기 위해 아이언우드 칩 출시

페이지 정보

본문

(퍼플렉시티가 정리한 기사)

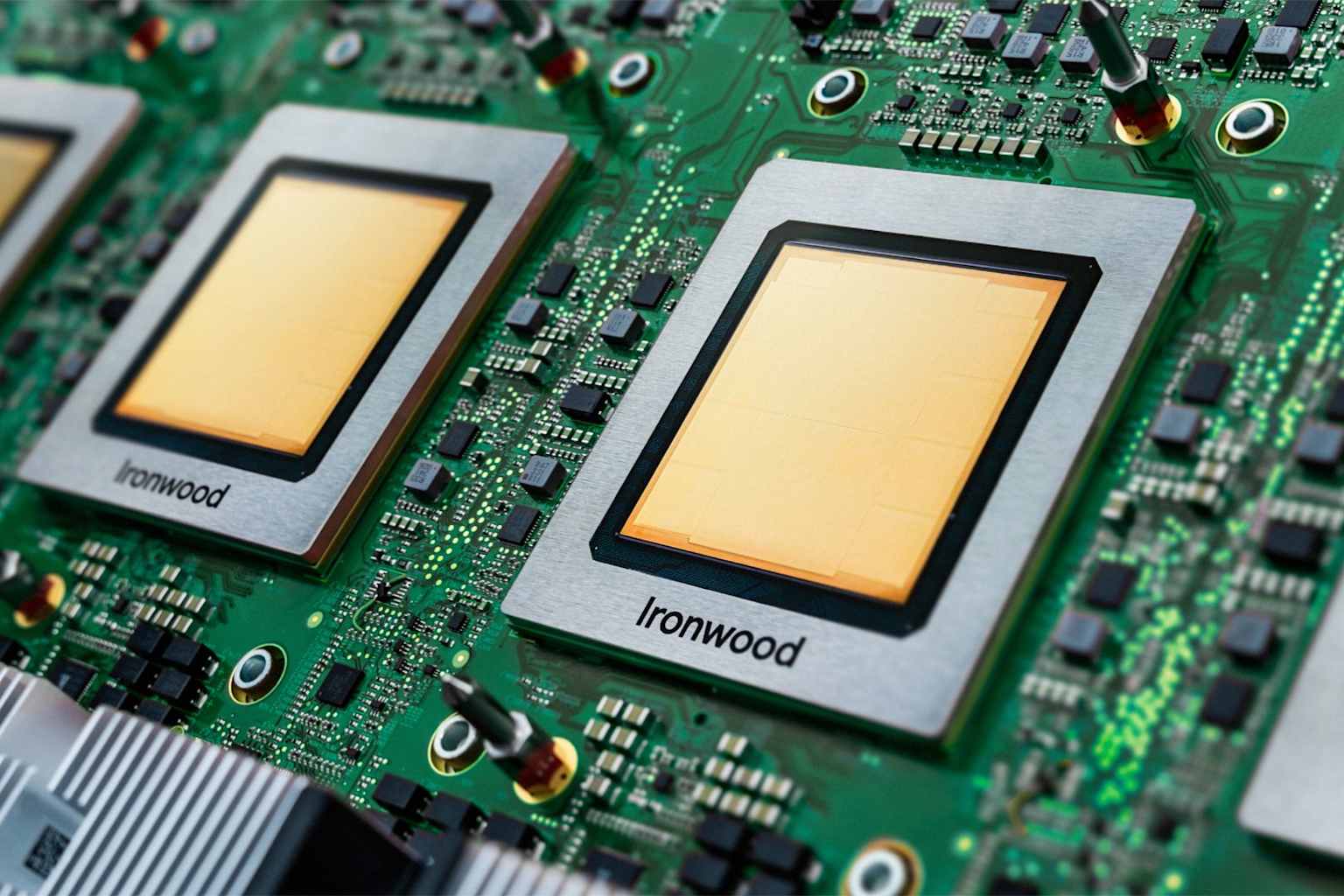

Google은 이번 주 7세대 텐서 처리 장치인 Ironwood를 출시했으며, Nvidia의 Blackwell 아키텍처와 직접 경쟁할 수 있는 성능 사양을 갖추고 있습니다. 이 칩은 앞으로 몇 주 내에 클라우드 고객들에게 일반적으로 제공될 예정이며, 이는 제3자 GPU에 대한 의존도를 줄이는 동시에 급성장하는 AI 인프라 시장에서 더 큰 점유율을 확보하려는 이 거대 기술 기업의 노력이 확대되고 있음을 나타냅니다.

Ironwood는 Google의 TPU v5p 대비 최대 10배의 피크 성능을 제공하며, Trillium으로도 알려진 이전 버전인 TPU v6e와 비교하여 칩당 4배 이상의 성능을 제공합니다. 각 칩은 4,614 FP8 테라플롭스의 성능을 제공하며 192GB의 HBM3E 메모리를 탑재하여 최대 7.37TB/s의 대역폭을 제공합니다. 이 시스템은 단일 포드에서 최대 9,216개의 칩으로 확장할 수 있으며, Google의 기술 문서에 따르면 42.5 FP8 엑사플롭스의 컴퓨팅 성능을 제공하는데, 이는 경쟁 시스템보다 약 118배 더 많은 수치입니다.

주요 고객들이 시장 변화를 예고하다

Claude 모델을 개발한 AI 스타트업 Anthropic은 10월 말, Google Cloud와의 획기적인 파트너십 확대의 일환으로 최대 100만 개의 TPU를 배치할 계획이라고 발표했습니다. 수백억 달러 규모의 이 거래를 통해 Anthropic은 2026년에 온라인으로 제공될 1기가와트 이상의 컴퓨팅 용량에 접근할 수 있게 됩니다. Anthropic의 최고재무책임자(CFO) Krishna Rao는 확장된 용량이 "기하급수적으로 증가하는 수요를 충족하는 동시에 우리 모델을 업계 최첨단에 유지할 수 있도록 보장한다"고 말했습니다.

크리에이티브 소프트웨어 도구로 잘 알려진 Lightricks도 텍스트와 이미지 입력을 결합한 멀티모달 모델 LTX-2를 훈련시키기 위해 Ironwood를 사용하고 있습니다. Google 자체도 Gemini, Veo, Imagen을 포함한 최첨단 AI 모델을 훈련하고 배포하기 위해 TPU를 사용합니다.

인프라 경쟁이 심화된다

Ironwood 출시는 Nvidia의 지배적인 GPU를 넘어 차별화된 AI 인프라를 제공하기 위한 클라우드 제공업체 간의 치열한 경쟁을 강조합니다. Google은 2025년 자본 지출을 이전 예상치인 850억 달러에서 910억 달러에서 930억 달러 사이로 늘리고 있으며, 대부분은 AI 인프라에 투입됩니다. CEO Sundar Pichai는 지난달 애널리스트들에게 회사가 2025년 3분기까지 지난 2년 동안보다 더 많은 10억 달러 이상의 거래를 체결했다고 말했습니다.

Google Cloud는 3분기에 전년 대비 34%의 매출 성장을 기록하며 151억 5천만 달러에 도달했습니다. Pichai는 이러한 성장을 "TPU 기반 솔루션을 포함한 AI 인프라 제품에 대한 상당한 수요"에 기인한다고 밝혔습니다. 회사의 클라우드 백로그는 전 분기 대비 46% 증가하여 1,550억 달러를 기록했습니다.

Ironwood와 함께 Google은 N4A 가상 머신과 C4A 베어 메탈 인스턴스를 포함한 새로운 Arm 기반 Axion 프로세서를 공개했습니다. 회사는 N4A가 비교 가능한 x86 기반 가상 머신의 최대 2배의 가격 대비 성능을 제공한다고 밝혔습니다.