영국 학생 92% AI 사용, 윤리성 문제 대두

페이지 정보

본문

(퍼플렉시티가 정리한 기사)

인공지능은 고등 교육을 빠르게 재편하고 있지만, 이러한 변화는 학생 학습, 비판적 사고, 그리고 학문적 진실성에 미치는 영향에 대한 심각한 우려를 불러일으키고 있습니다. 최근 연구와 교육자들의 증언은 기술 발전이 교육의 목적과 가치에 대한 근본적인 질문과 충돌하는 복잡한 환경을 보여줍니다.

대학생들은 전례 없는 속도로 AI 도구를 받아들이고 있습니다. 영국 고등교육정책연구소(UK Higher Education Policy Institute)에 따르면, 2025년 대학생의 92%가 AI를 적극적으로 사용하고 있었으며, 이는 2024년의 66%에서 드라마틱하게 증가한 수치입니다. 이들 중 88%는 과제 수행, 개념 설명, 기사 요약, 그리고 직접 글 생성에 생성형 AI를 활용했습니다.

우려는 단순한 부정행위 고발을 훨씬 넘어섭니다. 요크대학교(University of York)의 레오 맥캔(Leo McCann) 교수와 사이먼 스위니(Simon Sweeney) 교수는 최근 가디언(Guardian) 기고문에서 학생들 사이에 부적절한 AI 사용이 만연하며, 많은 평가가 “ChatGPT를 통한 필터링”을 거치고 있다고 지적합니다. 그들은 AI로 생성된 학술 과제 답변이 종종 “일반적이고, 영감을 주지 못하며, 사실과 다른 경우가 많다”고 관찰했다고 밝혔습니다. 한 예로, 1922년 헨리 포드(Henry Ford)의 기사를 분석한 학생들이 이 논란적인 산업가를 “정교한 HR 성과 기능을 만든 인물”로 묘사하고, 그를 “변혁적 리더”라고 특징지었습니다.

압박 속의 학문적 정직성

AI 사용의 급증은 연구자들이 “악성 문제(wicked problem)“라고 부르는, 명확한 해결책이 없는 문제를 대학에 야기했습니다. 최근 20명의 대학 교육자를 대상으로 한 연구에서는, 평가를 AI에 더 저항적으로 만들려는 시도가 종종 교육 목표를 희생시킨다는 사실이 밝혀졌습니다. 한 교육자는 “우리는 평가를 AI에 더 저항적으로 만들 수 있지만, 너무 경직시킨다면 창의성보다는 준수 여부만을 테스트하게 된다”고 언급했습니다.

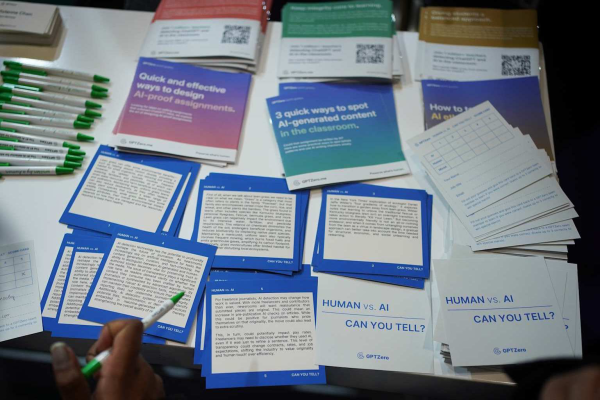

이러한 문제로 인해 대학들은 급하게 새로운 정책과 탐지 도구를 도입하고 있습니다. 그러나 AI 탐지 소프트웨어는 신뢰도가 낮아, 높은 오류율로 인해 정직한 학생들에게도 잘못된 누명을 씌우는 경우가 많습니다. 실제로 상황이 너무 심각해져, 버팔로 대학의 AI 탐지 서비스를 중단하라는 청원에 1,000명 이상의 사람들이 서명한 바 있습니다. 이는 여러 대학원생이 잘못된 비행 혐의를 받게 된 사건이 발생한 뒤였습니다.

관련성 격차

일부 전문가들은 AI의 광범위한 사용이 더 깊은 문제를 반영한다고 주장합니다. 학생들은 자신들이 시대에 뒤떨어진 기술을 개발하도록 요구받고 있음을 인식한다는 것입니다. 세계경제포럼(World Economic Forum)의 2025 미래 직업 보고서에 따르면, AI가 점점 더 잘 다루는 일상적인 읽기, 쓰기, 수학적 연산 능력은 점차 덜 중요해지고 있습니다. 학생들이 AI를 사용하는 것은 게으름 때문이 아니라, 점점 가치가 줄어드는 기술을 연습하라는 요구를 받고 있기 때문일 수 있습니다.

변화를 위한 요구

교육자들은 다양한 전략으로 대응하고 있습니다. 일부는 인공지능 부정행위에 취약한 과제를 포기하고, 더 창의적이고 개인화된 과제로 대체하고 있습니다. 또 다른 이들은 인공지능을 위협이 아닌 학습 도구로 여기며, 투명한 인공지능 통합을 옹호합니다. MIT를 비롯한 여러 기관은 인공지능 탐지 소프트웨어에만 의존하지 말라는 지침을 발표했습니다.

이 논쟁은 인공지능이 지배하는 세상에서 교육의 역할에 대한 더 광범위한 질문을 반영합니다. 일부 교사는 인공지능이 학생과 교사의 ‘성장’을 저해할 것이라고 우려하는 반면, 다른 이들은 인공지능이 미래 직장의 불가피한 일부임을 받아들여야 한다고 주장합니다.

McCann과 Sweeney가 가디언에 보낸 서한에서 결론을 내리듯, 인공지능이 일, 교육, 일상생활에 미칠 영향을 이해하기 위해서는 ‘지나치게 축하하기보다 더 비판적인 관점’이 필요합니다. 고등교육의 과제는 인간만이 할 수 있는 깊이 있는 사고와 비판적 분석을 유지하면서도 인공지능의 이점을 활용할 수 있는 방안을 찾는 것입니다.