오픈AI, 2030년까지 4,500억 달러 규모의 인프라 계획 발표

페이지 정보

본문

(퍼플렉시티가 정리한 기사)

OpenAI는 기술 역사상 가장 야심찬 인프라 지출 계획 중 하나를 착수했습니다. 2030년까지 맞춤형 칩 개발, 대규모 데이터 센터 확장, 전례 없는 컴퓨팅 용량 조달을 아우르는 총 4,500억 달러 규모의 투자 전략을 발표한 것입니다. 여러 파트너십과 내부 전망을 통해 상세히 공개된 이 대규모 계획은 OpenAI의 CFO 사라 프라이어가 "항상 컴퓨트가 부족한 상태"라고 부르는 상황에 대응하기 위한 회사의 움직임을 나타냅니다. 이러한 제약으로 인해 제품 출시가 지연되고, 고급 AI 기능 배포가 제한되어 왔습니다.

이번 투자는 OpenAI의 인프라 환경을 근본적으로 재편하고, 기존 클라우드 제공업체로부터 회사가 장기적으로 독립할 수 있는 역량을 갖추기 위한 여러 주요 요소를 포함합니다.

스타게이트 프로젝트, 대규모 데이터 센터 확장 주도

오픈AI 전략의 중심에는 'Stargate 프로젝트'가 있다. SoftBank, Oracle, 투자기업 MGX와의 5,000억 달러 규모의 합작 투자로, 2029년까지 미국 전역에 10기가와트의 AI 컴퓨팅 능력을 구축하는 것을 목표로 한다. 이 프로젝트는 2025년 1월 트럼프 대통령이 공식 발표했으며, 정부 관계자들은 이를 "미국 역사상 가장 야심찬 인프라 사업 중 하나"라고 설명한다.

9월에는 오픈AI가 오라클과 3,000억 달러 규모의 계약을 공식화했다. 이 계약은 2027년부터 약 5년 동안 진행되며, 추가로 4.5기가와트의 데이터 센터 용량을 제공할 예정이다. 이로 인해 200만 개 이상의 AI 칩이 지원될 것으로 기대된다. 1단계인 'Stargate I'은 텍사스 주 애빌린에서 이미 운영 중이며, 오라클은 Nvidia GB200 랙을 공급하고 있으며, 이 시설에서는 초기 AI 학습 및 추론 작업이 이루어지고 있다.

맞춤형 칩 개발로 엔비디아 의존도 감소

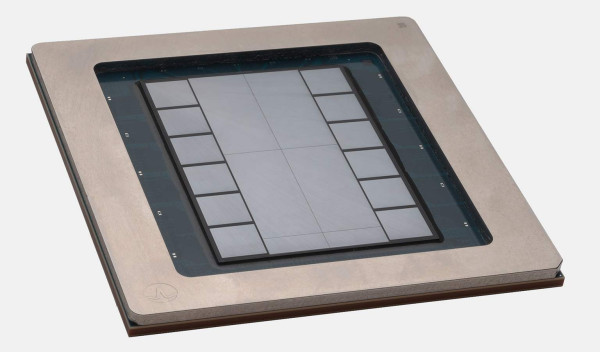

OpenAI와 Broadcom(Broadcom Inc.)의 파트너십은 독자적인 하드웨어로의 전략적 전환을 의미합니다. 두 회사는 맞춤형 AI 추론 칩에 대해 100억 달러 규모의 계약을 최종 체결했으며, 대량 생산은 2026년으로 예정되어 있습니다. 이 애플리케이션 특화 집적 회로(ASIC)는 TSMC의 3나노미터 공정을 활용해 제조되며, 상업적으로 판매되지 않고 오직 OpenAI의 데이터 센터에서만 사용될 예정입니다.

이 맞춤형 칩은 OpenAI가 겪고 있는 심각한 컴퓨팅 자원 부족을 해결하기 위해 고안되었습니다. CFO 사라 프라이어는 이를 회사의 주요 운영상 제약이라고 밝혔습니다. 프라이어는 "우리가 당면한 가장 큰 문제는 끊임없이 '컴퓨트 부족' 상태에 있다는 것입니다"라고 설명했으며, 이러한 부족 때문에 Sora 비디오 생성 모델과 같은 제품의 출시가 지연되고, 일부 기능은 기업 고객에게 제공되지 못했다고 덧붙였습니다.

Broadcom CEO 혹 탄은 실적 발표에서 OpenAI로 널리 알려진 신규 고객으로부터 100억 달러 이상의 주문을 확보했으며, 2026회계연도 3분기부터 납품이 시작될 것이라고 확인했습니다. 이 파트너십은 Broadcom을 AI 하드웨어 분야에서 Nvidia의 지배력을 위협하는 주요 경쟁자로 자리매김시키며, 해당 칩 주문이 수천 개의 서버 랙에 분산된 1~2백만 개 XPU에 해당할 수 있습니다.

1,000억 달러 백업 서버 전략으로 신뢰성 보장

주요 인프라를 넘어, OpenAI는 향후 5년간 클라우드 공급업체로부터 백업 서버에 1,000억 달러를 투자할 계획입니다. 이는 2030년까지 서버 임대에 3,500억 달러를 투입하기로 한 기존 약속과는 별도의 예산입니다. 이러한 추가 용량은 제품 출시나 예기치 못한 사용량 급증 등 수요가 급격히 증가하는 상황에 대응하기 위해 마련된 것으로, 서비스 제한이나 출시 지연을 초래해온 지속적인 문제를 해결하기 위해서입니다.

OpenAI 경영진은 이 백업 서버를 “수익 창출이 가능하다(monetiable)”고 보고 있으며, 이를 통해 연구 애플리케이션이나 일반적으로 수요가 낮은 기간 동안 제품 사용 증가를 통해 추가 수익을 얻을 수도 있다고 밝혔습니다. 주요 서버 지출과 합산할 경우, OpenAI는 향후 5년 동안 서버 임대 비용으로 연평균 약 850억 달러를 지출할 것으로 예상하고 있습니다.

금융 아키텍처는 전례 없는 규모를 지원합니다

막대한 인프라 투자는 오픈AI의 수정된 지출 예상에 의해 뒷받침되고 있습니다. 이는 2029년까지 1,150억 달러의 현금 소진이 예상되며, 이는 이전 추정치보다 800억 달러 증가한 수치입니다. 연간 지출은 2025년 80억 달러에서 2028-2029년에는 최대 450억~500억 달러까지 증가할 것으로 전망되며, 주로 컴퓨팅 비용과 인프라 확장에 의해 주도됩니다.

이 확장을 위해 오픈AI는와의 파트너십을 재구성하고 있으며, 수익 공유 비율을 현재의 20%에서 2030년까지 약 8~10%로 낮출 예정입니다. 이 조정으로 수십억 달러의 자금을 재투자할 수 있게 되며, 마이크로소프트는 오픈AI가 영리 목적의 공익법인(Public Benefit Corporation)으로 전환할 계획에 따라 지분 보유 등 다양한 방식으로 보상을 받게 됩니다.